Que mejor forma de ver como realizar una auditoría seo que viendo un caso real. En este posts realizare la auditoria seo y mejoras que correspondan a una de mis web, al ser mía puedo permitirme publicar datos reales y así podréis ir viendo los efectos que van trayendo estos cambios.

Auditoría SEO

Datos generales del proyecto

Lo primero es tener unos datos generales de la web a analizar para ir haciéndonos una idea de lo que podemos encontrar. En este caso vamos a trabajar en www.maschef.com una web de recetas de cocina que nació con la simple idea de recopilar las recetas para tenerlas a mano y poder quitar papeles de la cocina, con lo que tampoco intentaremos desbancar a los grandes ya que además es un nicho muy competido y con paginas de mucha autoridad. Pero estoy seguro que los cambios no le van a sentar mal y alguna mejora podremos notar.

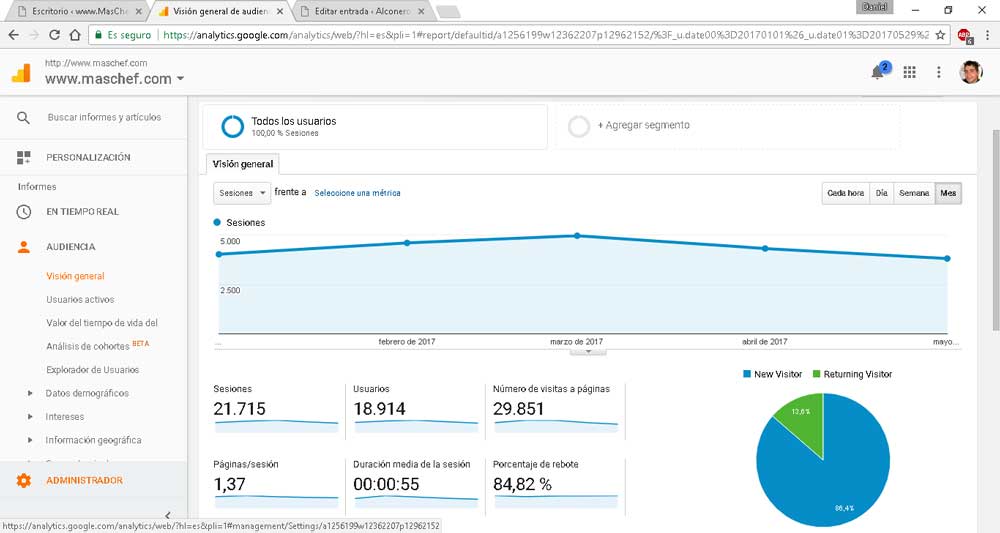

Para poder comparar aquí tenemos el analytics actual donde podemos ver que maschef ronda una media de 4000 visitas mensuales, lo que es lo mismo a una 140 sesiones diarias.

Analytics a fecha del 30 de Mayo del 2017, antes de empezar con los cambios.

Estado de la indexación

Utilizando la extensión para el chrome de SEOquake podemos ver que la web cuenta con 629 paginas indexadas en google, y es una pagina que por lo menos existe desde el 2008 con lo que cuenta con una buena antigüedad y eso le gusta a google.

¿Errores de rastreo?

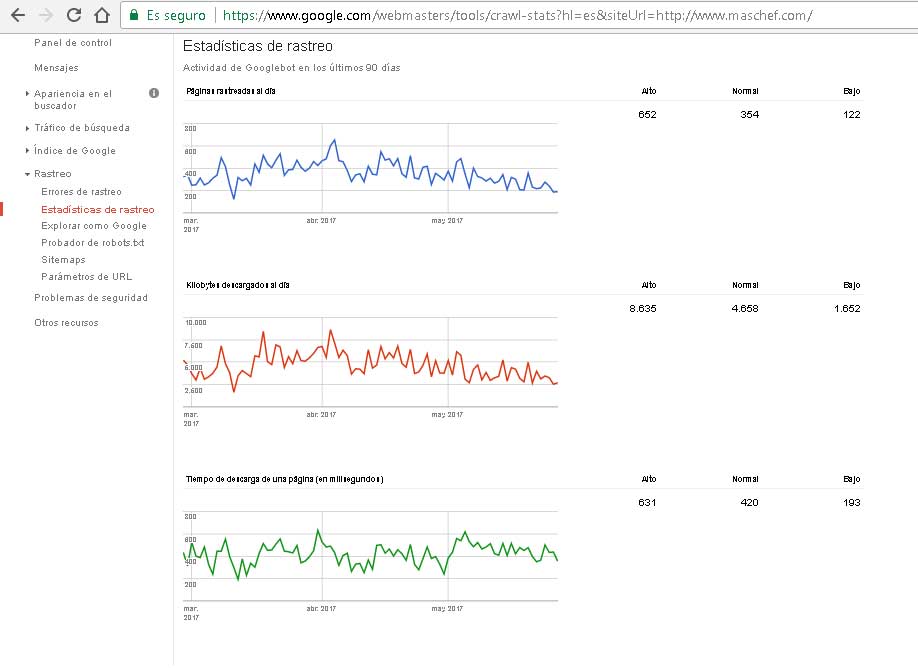

Ahora para seguir recopilando datos pasaremos a entrar en el search console (Tutorial de Google Search Console), muy útil para nuestro diagnostico, podemos comprobar en Webmasters de Google > Rastreo > Errores de Rastreo que no existen errores y que la frecuencia de rastreo Webmasters de Google > Rastreo > Estadísticas de Rastreo ha bajado ligeramente, muy comprensible dado que la web se esta actualizando poquísimo en el ultimo año.

Sitemap y Robots.txt

Ahora nos encontramos en Webmasters de Google > Rastreo > Sitemaps y descubrimos que el sitemap que se le esta pasando a google es incorrecto, algún cambio en los plugins a propiciado que el sitemap que le indicamos a google ya no exista. ¡¡Olé, Olé!! toma error fácil de arreglar que acabamos de descubrir.

Revisamos también la existencia del robots.txt, y vemos simplemente que no bloquee nada que no tenga que hacer, y como era de esperar vemos que el sitemap que indica también es incorrecto. Más adelante ya revisaremos lo contrarío, si queremos bloquear alguna cosa que no queremos que se indexe.

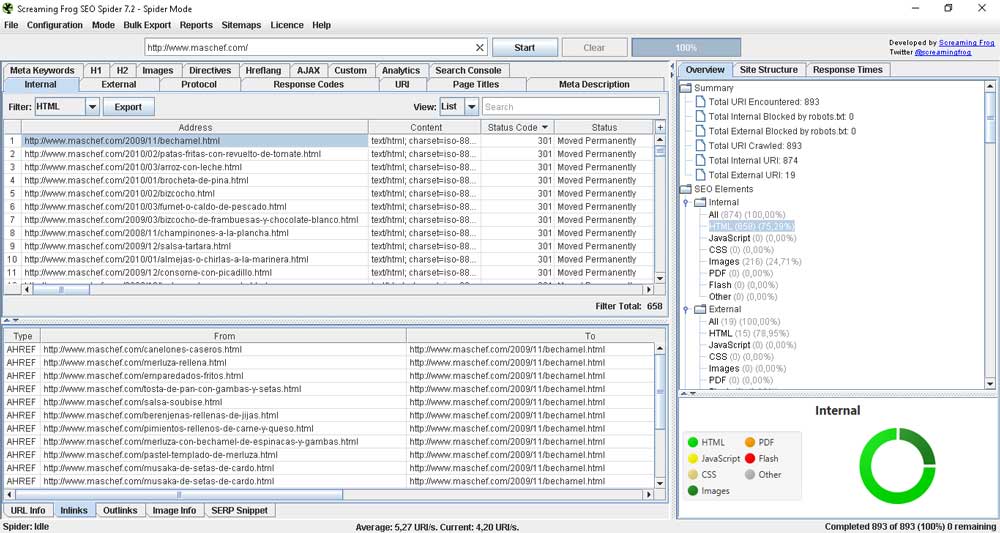

Urls indexables con screaming frog

Ahora pasamos al screaming frog (Tutorial de Screaming Frog), autorizamos a la API de analytics y la de search console, y analizamos la web. De esta forma podemos saber que tenemos 610 urls indexables y 48 redirecciones 301 por eso google aun tiene 629 paginas indexadas. Ya sabemos que tendremos que revisar esos 301 porque seguro que se pueden solucionar y así ahorrar tiempo de rastreo. Ahora gracias a tener la API de analytics podemos ver que tenemos 387 paginas que no han recibido una sola visita en los últimos 3 meses, esas urls habrá que revisarlas porque es mucho contenido perdido o urls que a lo mejor no nos interesa que estén indexadas.

Cambios a realizar para un buen trabajo SEO

Un pequeño resumen de las cosas que ya sabemos que hay que tocar:

- Cambiar la url del sitemap tanto en el search console como en el robots.txt. (Realizado el 30/05/2017)

- Revisar las 48 redirecciones 301 que están siendo enlazadas desde alguna url interna y modificar esos enlaces (gracias screaming frog por existir). Para esto utilizare el plugin Better Search Remplace que me hará la tarea mucho más sencilla. (Realizado el 31/05/2017)

- Marcar las url que no queremos que estén indexadas y las que creemos que nos pueden aportar trafico interesante de las 387 urls indexadas por google que no reciben nada de trafico. Para ellos las exportamos a excel desde el screaming frog para realizarlo de una forma más cómoda.

- Las que no queremos que estén idexadas ponerlas como noindex o bloquear desde robots.

- Nos encontramos con 27 urls indexadas antiguas que tienen 301 a url nueva, por lo que es normal que no aporten trafico. En el Search Console de Google y gracias a la extensión Bulk url removal le indicamos al buscador que elimine de su indice todas estas urls. (Realizado el 14/06/2017)

- Las que nos pueden aportar trafico revisar el seo onpage y actualizar las recetas para que mejoren posiciones. (Esto poco a poco que 387 no se hace en un rato).

- Vemos que tenemos 101 urls de recetas que hay que revisar urgentemente el seo onpage

- 241 urls se tratan de tags, se están utilizando para crear urls por ingredientes, por ejemplo «recetas de arroz» por eso están como indexables, pero hay que revisar para que tengan su propio texto.

- Se hace una limpieza en los tags, eliminando los que solo tienen una receta y unificando los que estaban en plural y singular. (Realizando el 14/06/2017)

- Las que no queremos que estén idexadas ponerlas como noindex o bloquear desde robots.

Ahora toca trabajo duro para ir arreglando estos puntos y cuando estén listos iré actualizando el posts con los cambios realizados y seguiremos avanzando en la auditoría y demás trabajos seo.

Si mientras saco tiempo para actualizar este post, quieres aprender mas sobre seo, puedes visitar el post sobre concurso seo cantineoqueteveo esto convencido de que aprenderas algún truco o tip gracias a la participación de los mejores seos de España.

Excelentes recomendaciones sobre cambios a realizar para un buen SEO que interesante información la que manejas en este post, en mi caso desconocía de estas herramientas, me toco contar con la asesoría de una Consultoría de Marketing que me orientara a mantenerme al día estos procesos, realmente tienen un valor muy importante y se que a estas alturas pueden ser de utilidad para muchas personas… Pero tomare en cuenta estas herramientas a ver si puedo realizarlo por mi cuenta, Gracias por esta infor. y estar dispuesto a ir actualizando con contenido para seguir avanzando en auditoria y otros trabajos seo.

Samsung 900SL plus

22 Inch LG Flatron